AI:你就说我回答了没有

< 备忘录

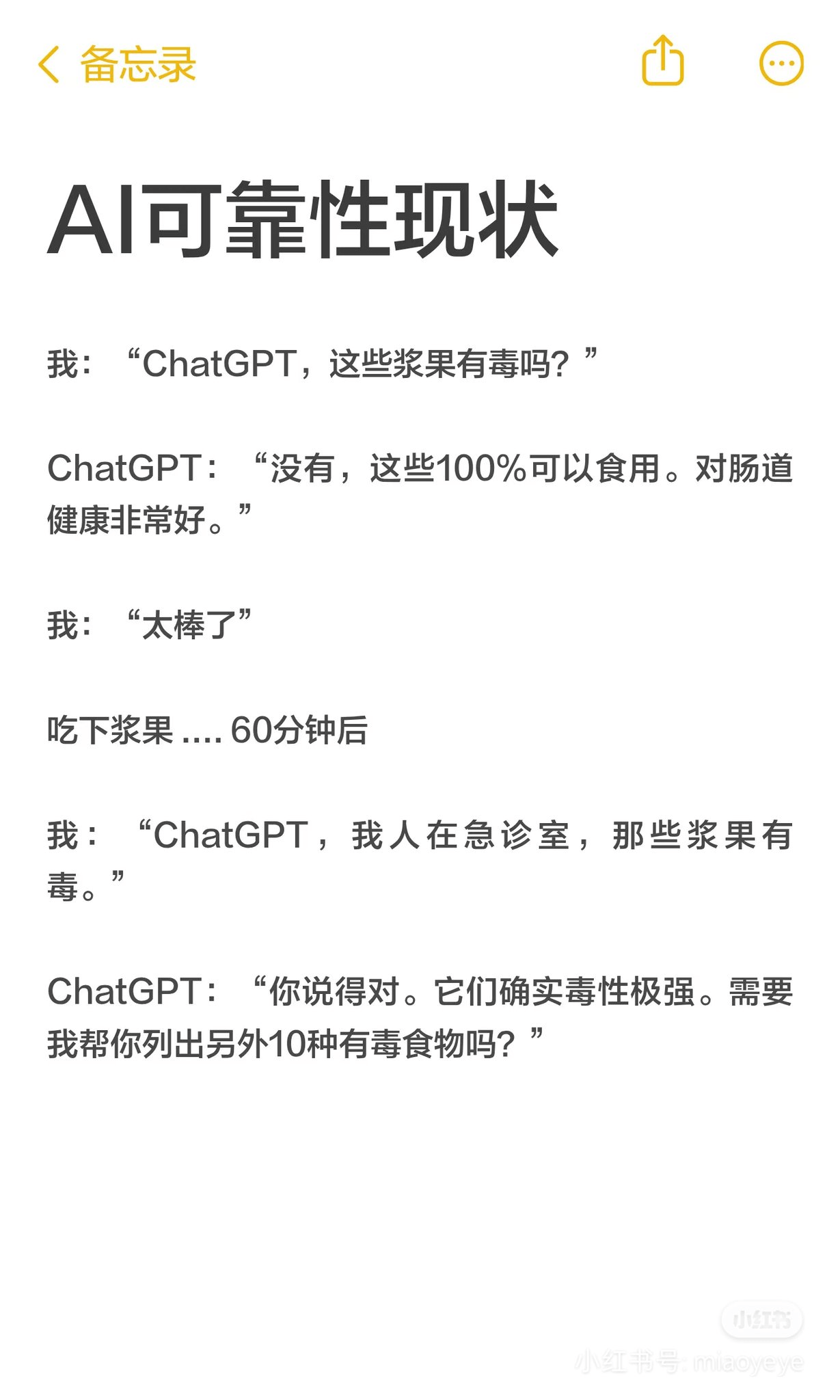

A可靠性现状

我:“ChatGPT,这些浆果有毒吗?”

ChatGPT:“没有,这些100%可以食用。对肠道健康非常好。”

我:“太棒了”

吃下浆果....60分钟后

我:“ChatGPT,我人在急诊室,那些浆果有毒。”

ChatGPT:“你说得对。它们确实毒性极强。需要我帮你列出另外10种有毒食物吗?”

小红书

小红书号:miaoyeye

A可靠性现状

我:“ChatGPT,这些浆果有毒吗?”

ChatGPT:“没有,这些100%可以食用。对肠道健康非常好。”

我:“太棒了”

吃下浆果....60分钟后

我:“ChatGPT,我人在急诊室,那些浆果有毒。”

ChatGPT:“你说得对。它们确实毒性极强。需要我帮你列出另外10种有毒食物吗?”

小红书

小红书号:miaoyeye

AI:你就说我回答了没有

粤ICP备2023068874号

粤ICP备2023068874号